什么是 NVIDIA Build

NVIDIA Build 是由英伟达官方推出的生成式 AI 体验与开发平台。它将全球领先的开源大模型(如 Llama 3、Gemma、Mixtral 等)以及英伟达自研的专项模型,通过 NVIDIA NIM(微服务架构)进行高度优化,并以 API 的形式提供给用户。

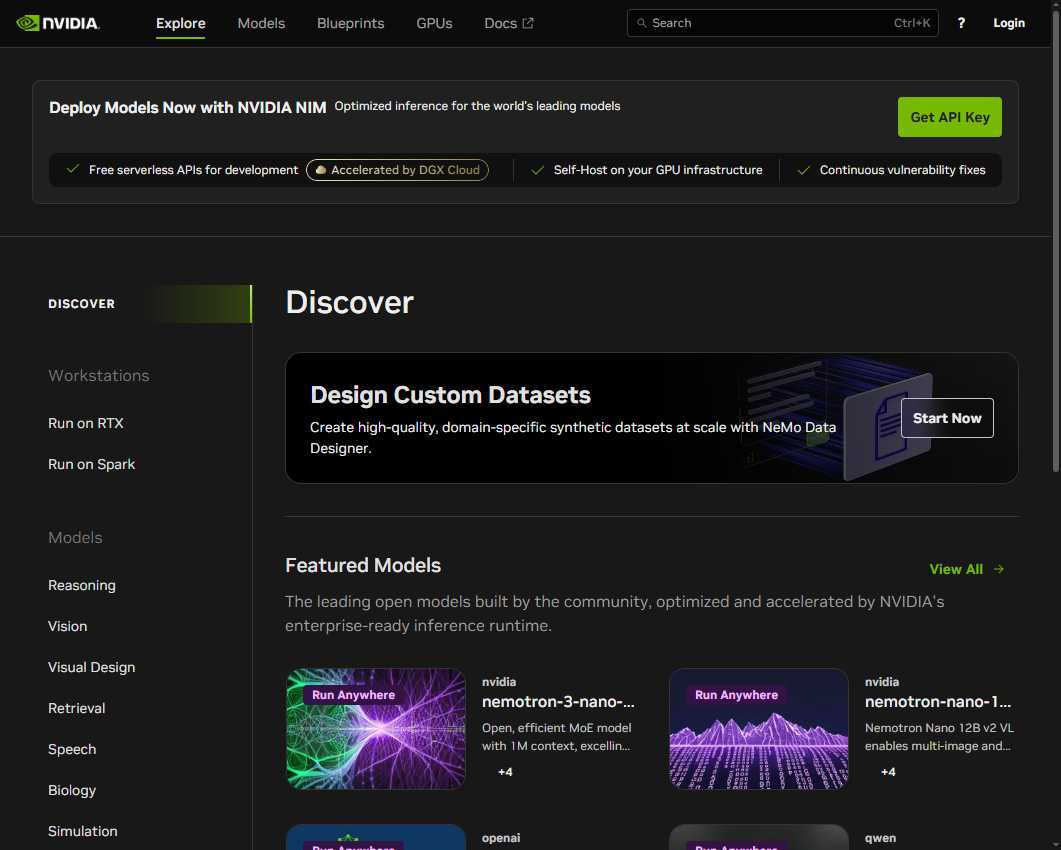

NVIDIA Build 网站截图

核心功能与特色

-

模型超市:平台集成了多种类型的模型,包括大型语言模型(LLM)、视觉模型、图像生成视频模型、语音模型以及专门用于医疗生物、气候预测、工业模拟的垂直领域模型。

-

极致性能优化:所有模型都经过 NVIDIA TensorRT 和 Triton 推理服务器的优化,运行在 DGX Cloud 基础设施上,确保了极高的推理速度和超低延迟。

-

生产级 API:提供标准化的 API 接口,开发者可以轻松地将这些模型集成到自己的应用程序中。

-

蓝图方案(Blueprints):不仅提供单个模型,还提供完整的 AI 解决方案模板,例如企业级 RAG(检索增强生成)、智能体(AI Agents)开发框架等。

-

多环境运行:支持在云端 API 运行,也支持下载 NIM 容器在本地 RTX 工作站或企业私有数据中心部署。

技术原理

NVIDIA Build 的核心技术支柱是 NVIDIA NIM(NVIDIA Inference Microservices)。 NIM 是一种预先包装好的推理微服务,它将 AI 模型、优化引擎(TensorRT)、推理服务器和行业标准的 APIs 封装在一个容器中。这种架构解决了 AI 模型部署中常见的兼容性、扩展性和性能损耗问题,实现了“一次打包,到处运行”。

使用教程

-

访问官网:进入 NVIDIA Build 的 Explore 页面。

-

选择模型:在 Discover 页面浏览感兴趣的模型,点击进入详情页。

-

在线体验:无需注册即可在页面右侧的对话框或参数面板中进行交互式测试。

-

获取 API Key:若需在代码中调用,点击 Get API Key 按钮,登录英伟达账号后即可生成密钥。

-

代码集成:页面会提供 Python、Curl 等多种语言的调用示例,直接复制到你的开发环境即可使用。

应用场景

-

企业智能助理:利用 Llama 或 Nemotron 模型构建能够处理内部文档、生成报告的 AI 智能体。

-

多媒体创作:使用 Stable Diffusion XL 进行文生图,或使用 SVD 模型进行图生视频创作。

-

科学研究:利用专门的生物模型进行蛋白质结构预测,或利用气候模型进行高精度天气模拟。

-

开发者原型开发:快速验证 AI 功能逻辑,无需前期投入巨大的算力成本。

收费模式

-

免费额度:个人开发者和爱好者可以免费在线体验模型,并获得一定数额的免费 API 调用次数(通常用于开发和测试阶段)。

-

企业收费:对于需要在大规模生产环境下使用、或者需要下载 NIM 容器进行私有化部署的企业,英伟达通过 NVIDIA AI Enterprise 套件进行授权收费,提供持续的安全更新和技术支持。

适用人群

-

AI 开发者:寻找高性能 API 进行应用开发的程序员。

-

企业架构师:评估不同模型性能,规划企业 AI 基础设施的决策者。

-

研究人员:利用专业领域模型进行学术研究的学者。

-

AI 爱好者:想要第一时间体验全球顶尖开源模型最新版本的用户。

优缺点分析

优点:

-

性能顶级:基于英伟达原生硬件优化,响应速度极快。

-

门槛极低:无需安装 CUDA 驱动或配置复杂的 Python 环境,开箱即用。

-

选型丰富:涵盖了目前市面上绝大多数主流的开源大模型。

-

安全合规:提供企业级的安全漏洞修复和隐私保护选项。

缺点:

-

纯英文界面:官网及文档暂无全中文支持,对部分国内用户有一定门槛。

-

免费限制:虽然可以免费体验,但大规模商业调用仍需付费。

-

依赖网络:云端 API 调用受网络环境影响。

常见问题及解决

-

API 次数用尽怎么办?对于非登录用户,有时可以通过清除浏览器缓存或使用无痕模式临时重置部分模型的体验次数。但长期建议注册账号获取官方 API Key。

-

模型不支持中文?部分自研模型或特定领域的模型对中文支持有限,建议使用翻译插件或选择支持多语言的大模型(如 Qwen 或 Llama 3 多语言版)。

-

无法连接服务?由于服务器位于海外,国内用户在访问时可能需要稳定的网络代理支持。

总结

NVIDIA Build 不仅仅是一个模型展示中心,它是英伟达构建 AI 生态的关键一环。它降低了 AI 应用的开发难度,让普通开发者也能享受到顶尖算力的加持。

数据统计

相关导航

可灵AI

Reve Image

讯飞星火

咚漫漫画

TTS Omni

蛙蛙写作

智谱清言